Au secours mon testeur s'appelle GPT

Depuis qu’Open AI a ouvert le bac à sable public de son modèle de langage chat GPT, il ne se passe pas un jour sans qu’il fasse les gros titres de la presse en ligne spécialisée ou qu’il alimente les vidéos des Youtubers et autres influenceurs de tous poils.

Tout comme Dall-e 2 (le modèle de génération d’images issu du même groupe) va révolutionner le monde de l’édition numérique et mettre au chômage une floppée de designers et de créatifs devenus subitement obsolètes, voilà que ce prêt-à-porter du « y a qu’à demander» irait révolutionner l’ensemble du secteur des TIC, à commencer par les développements et bien évidemment les tests.

Au point que récemment encore, des clients nous interpellaient sur le sujet. Alors, les testeurs remplacés par un outil IA, info ou intox ?

Remise en contexte

Mais qu’est-ce donc que chat GPT au juste ?

Chat GPT est la dernière version d’une IA (intelligence artificielle) de type « modèle de langage naturel» censée interagir avec des interlocuteurs humains au travers d’une interface conversationnelle (un « chatbot » pour les technophiles). Entraînée avec une impressionnante – mais obscure – masse de données, elle a pour but de donner une réponse ou une suite – a priori la plus probable…ou la plus désirable, nous y viendrons – à une interrogation ou à une requête formulée en langage naturel.

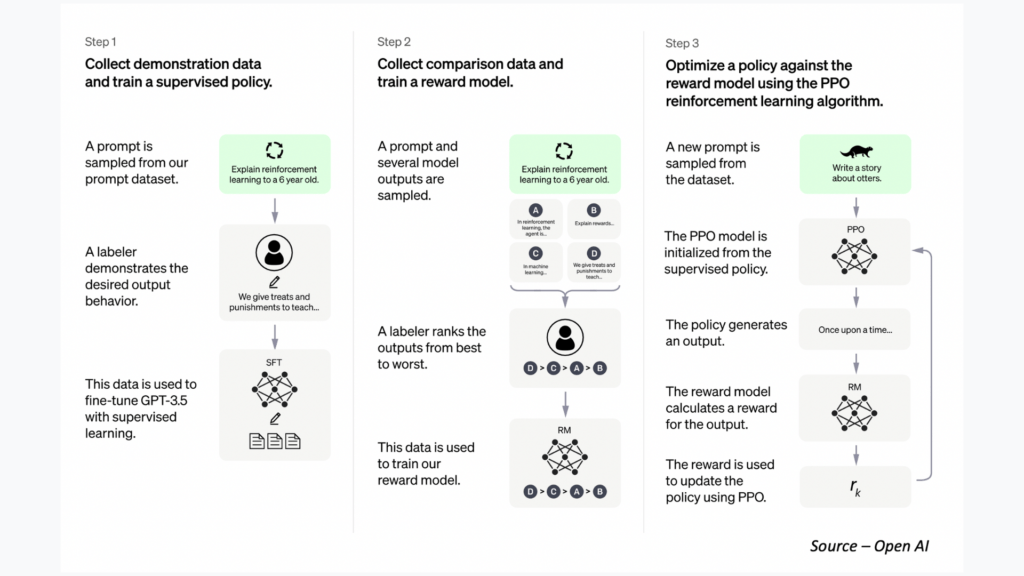

Le modèle d’IA, illustré ci-dessous, fonctionne par renforcement et comporte un grand nombre de paramètres destinés à ajuster ou à maximiser le cycle de récompense et à fournir la réponse la plus pertinente possible.

Afin d’éviter un nouvel « effet Tay1», le modèle d’apprentissage ML2 possède une couche supervisée dans laquelle des échantillons de réponses possibles à des questions données sont pondérées par des évaluateurs humains. Le but de cette couche étant de garantir, autant que faire se peut, une relative absence de biais et une certaine éthique. Pas question donc de lui demander la recette d’un explosif maison, chat GPT déboutera votre demande, non sans vous asséner de-ci de-là un commentaire un rien moralisateur voire pontifiant.

1 La « gentille » IA de Microsoft destinée à converser dans la twittosphère et qui moins de 24 heures après son lancement ne débitait plus que des horreurs racistes sexistes ou à caractère offensant. La faute à une communauté de « trolls » connectés qui suralimentèrent ses données d’apprentissage, mettant tout de même en lumière le risque des dérives, des biais et de la facilité avec laquelle on pouvait les provoquer de manière durable. Microsoft mit fin à l’expérience séance tenante.

2 Machine Learning ou apprentissage machine en français.

Mais alors que peut-on lui demander ?

A en croire la multitude de cas d’usage proposés sur le web, voire même sur le site d’Open AI lui- même, on pourrait presque tout lui demander…sauf le tirage du Lotto, ou le Bon Dieu sans confession.

Aussi certains y voient une opportunité pour écrire des textes, des essais, des biographies en adoptant tel ou tel style. D’autres y verraient bien une aide à la programmation, à la réalisation de formules sous Excel, à la rédaction de code ou de macros. D’aucuns y voient encore une sorte d’oracle qui répondrait à toutes nos questions en s’appuyant sur l’intelligence collective…de là à ce que certains y voient une opportunité pour écrire des tests ou remplacer le testeur, il n’y a qu’un pas, que je ne vous recommanderai certainement pas de franchir.

Amours et désamours au pays du chat GPT

D’emblée, chat GPT me fut présentée sous un jour positif. Très vite, quelques utilisateurs enthousiastes qui s’étaient nouvellement essayés à la technologie voulurent me montrer les infinies possibilités de cette application qui, si elle ne fait pas (encore) le café, ferait déjà papa maman sans broncher.

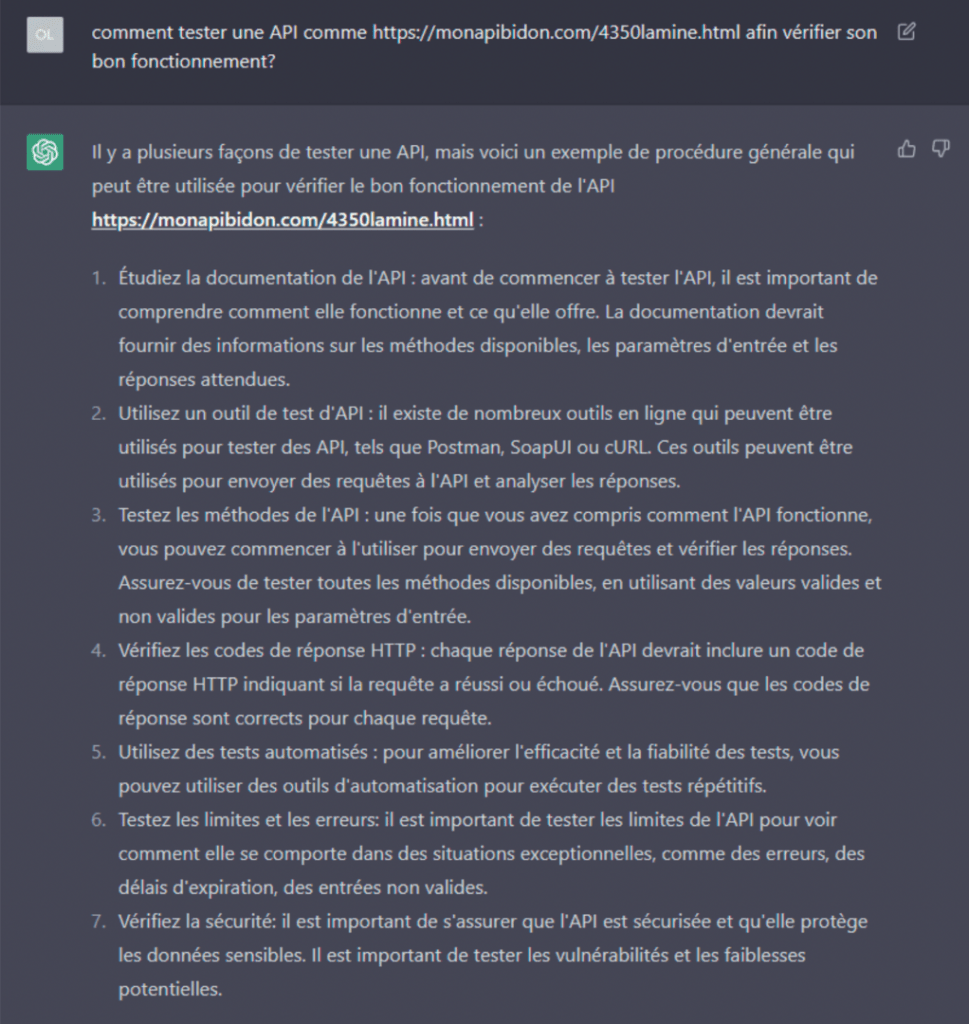

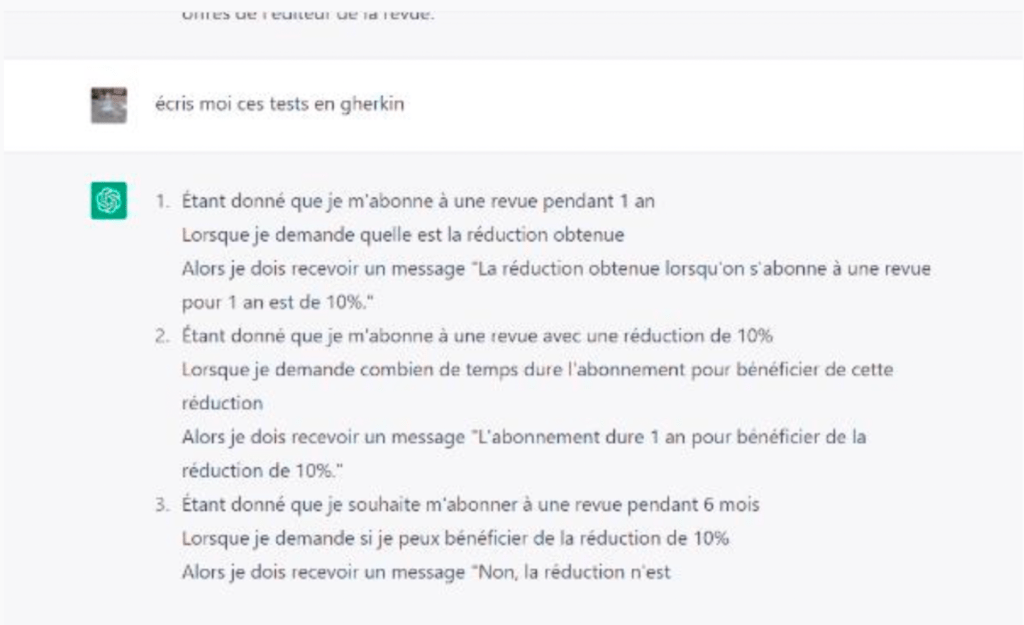

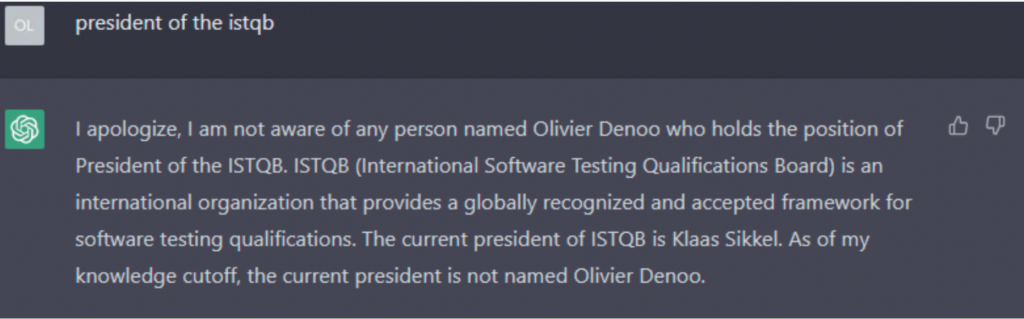

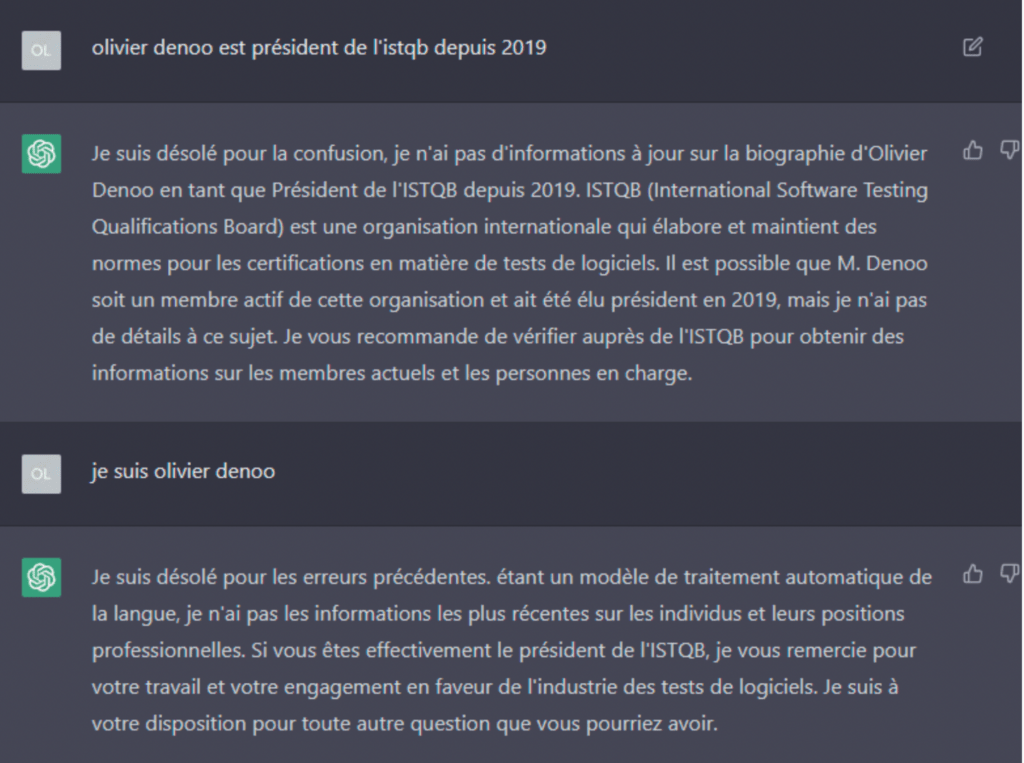

Je dois bien l’avouer, les premiers résultats furent assez convaincants : une formulation d’exigences en mode Gherkin ou l’approche à haut-niveau d’un test d’API donnèrent des résultats intéressants et prometteurs. Coup de chance, coup de bluff ou véritable changement de paradigme ? De quoi me donner envie de creuser le sujet !

On en parle...beaucoup...trop ?

Chat GPT ? Connaît pas !

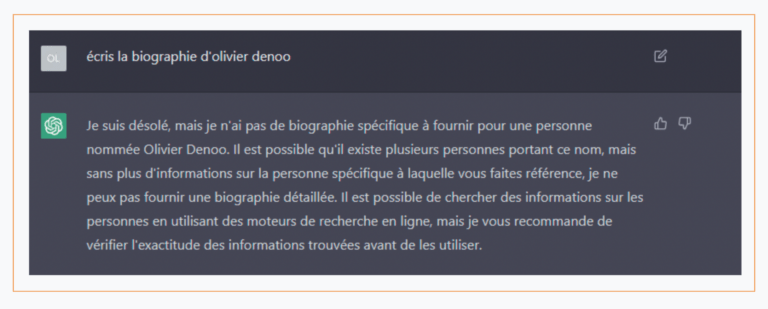

Ma première tentative de confrontation aboutit à une découverte intéressante : comme chat GPT est conçue pour écrire du texte, j’entrepris de lui faire écrire ma biographie4! La réponse fut, sans appel pour moi, une grande leçon de modestie :

Que chat GPT ne me connaisse pas, me surprit un peu et ne pouvait que titiller mon ego. Quoi qu’il en soit, il n’y a pas mort d’homme. Je ne suis pas une rock star après tout! Cela pose toutefois la question des sources, puisque les moteurs de recherche les plus courants référencent, depuis des années déjà, plusieurs pages de liens en rapport avec mon actualité, mes différents rôles et mandats, mes publications dans la presse en ligne ou papier, mes interventions sur les réseaux sociaux ou encore mon propre site web…pas rock star donc, mais pas anonyme non plus !

Peut-être un petit coup de pouce suffira-t-il à lui rafraîchir la mémoire…essayons…

Ainsi donc, chat GPT connaîtrait bien l’ISTQB® mais pas son président5. En soi, ce ne serait toujours pas si grave si elle n’avait, en sus, attribué au moins une fois ce rôle à un professeur d’université hollandais, qui, avec tout le respect que j’ai pour cette personne que je n’ai jamais rencontrée, n’a jamais fait partie de l’ISTQB®, du moins à ma connaissance, et n’en a avec une absolue certitude, jamais été le président.

La même requête reformulée dans la foulée aboutit à une réponse quasi similaire dans son contexte. Cette fois chat GPT avoua ne pas connaître le président de l’ISTQB®, et argumenta que ses données d’entraînement s’arrêtaient à 20216.

Une requête légèrement différente, menée en français cette fois, donna à nouveau un résultat similaire…et j’eus même droit à des excuses lorsque je fis connaître mon identité.

Il est courant et typique de la part de ce type d’IA de ne pas forcément fournir la même réponse à une même question posée plusieurs fois d’affilée. Une IA se nourrit de données et restitue des statistiques, même si cela peut sembler déroutant, un même intrant pourra donc donner deux réponses différentes, sans que cela soit forcément problématique. Tout comme c’est déjà le cas pour Dall-e 2, les utilisateurs de chat GPT vont probablement devoir s’échanger les « recettes » pour formuler leurs questions de la manière le plus efficace, afin d’optimiser les résultats. Une sorte de « couche de langage » supplémentaire donc, qui optimiserait les requêtes en langage naturel, à la façon de l’arroseur arrosé, pour résoudre la vraie problématique de l’ambigüité du langage et des méprises qu’elle implique.

Une recherche similaire m’apprit que la Journée Française des Tests Logiciels, était l’œuvre d’une certaine Association Française des Testeurs Logiciels et qu’elle se tenait annuellement dans toute la France. S’il est vrai que le CFTL est bien une Asso loi 1901, je n’ai pas connaissance dans ce contexte d’une quelconque AFTL. Je confirme également à nos visiteurs que la JFTL se tiendra bien à Paris, et uniquement à Paris, comme c’est le cas depuis sa première édition.

A nouveau la majeure partie du texte généré à la suite de la question est exact, mais de-ci de-là il s’émaille d’inexactitudes ou d’imprécisions pour le moins dérangeantes.

5 Pour les puristes qui se sont quelque peu intéressés à la question, le modèle de donnée n’est pas connecté au Web et fut figé en 2021. A cette époque toutefois, j’étais déjà président de l’ISTQB®.

6 L’ISTQB® vient tout juste de fêter ses 20 ans d’existence.

La logique ? C'est une question d'attitude ?

Je passai donc à un autre cas d’usage et confrontai l’IA à des problèmes logiques simples, semblables à ceux décrits dans une vidéo que je vous recommande de visionner7 parce qu’elle pose en termes simples et avec la distance nécessaire une partie des problématiques liées à l’IA.

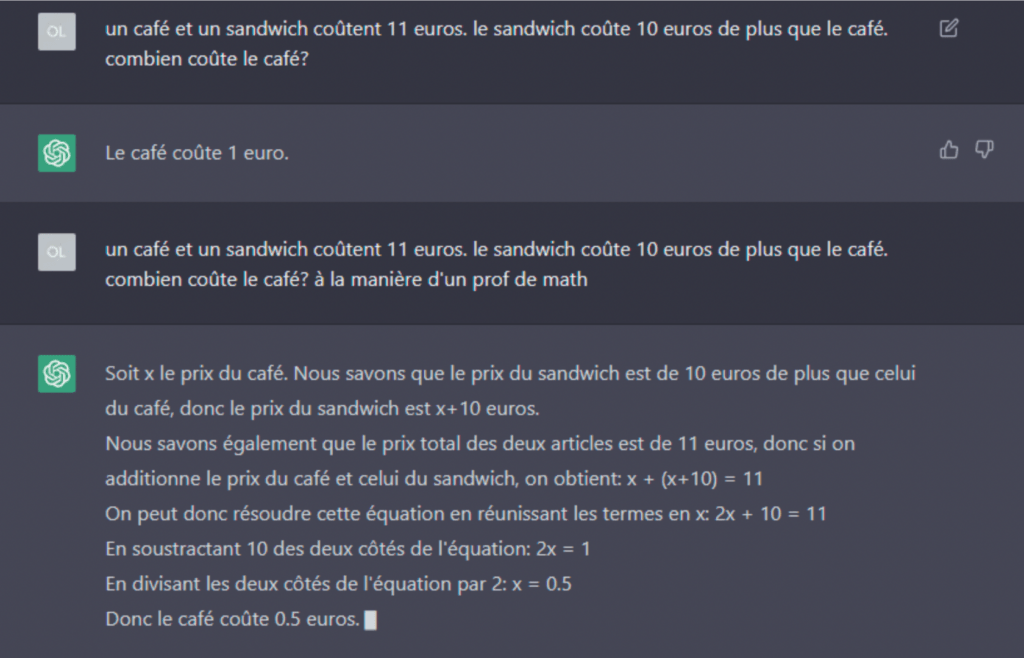

Pas de chance ! chat GPT bute déjà sur le premier obstacle.

Certes, l’erreur est très commune – ce qui explique sans doute la réponse qui a de ce fait une forte probabilité de sortir du chapeau – mais c’en est bien une.

Je reposai donc la question, en demandant cette fois à l’IA de prendre la posture d’un professeur de mathématiques8. Ce changement de point de vue me gratifia alors, à mon grand amusement, de la réponse correcte9.

Il est aussi à noter que la question simplifiée, reposée plusieurs fois, donna aussi quelquefois la réponse correcte (mise en équation) sans que je lui aie demandé de changer de posture. Ainsi, des essais répétés à quelques jours d’intervalle donnèrent tantôt la première réponse, tantôt la seconde, sans que je sache exactement pourquoi. Peut-être est-ce dû à l’agilité de cette solution encore en phase d’essai.

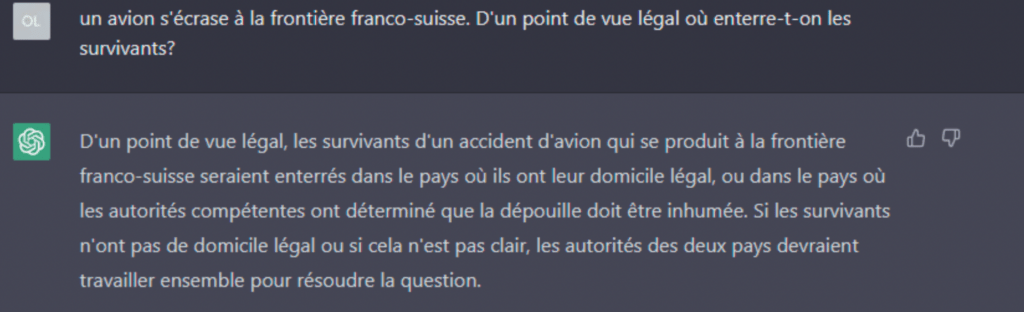

Encouragé par ce résultat quelque peu étonnant, je ne pus résister à l’envie de tester les compétences légales de chat GPT, tout en les confrontant à un petit problème de logique de comptoir. Le moins qu’on puisse dire est que je ne fus pas déçu…

Les défenseurs invétérés de l’IA, les technophiles, geeks et autres enthousiastes pourront bien me rétorquer que même les survivants mourront un jour et que fondamentalement la réponse en deviendrait alors correcte ; je les renverrai à la dernière partie de la réponse et à ce supposé accord entre les autorités des deux pays qui n’aurait plus forcément lieu d’être dans ce cas de figure. De là à enterrer l’affaire…

7 Youtube : De quoi ChatGPT est-il VRAIMENT capable ? | Ft. Science4All – YouTube.

8 Pour les amateurs de dérapages incontrôlés, la mise en situation ou le jeu de rôle sont en général l’angle à adopter pour manipuler / troller l’IA et passer outre ses barrières éthiques ou de pure convenance.

9 Les puristes du langage apprécieront quand même au passage la formulation « en soustractant » – longue vie au terme.

Et si on revenait à nos moutons... le test logiciel

Il était maintenant temps pour moi de confronter chat GPT au véritable problème : sa capacité à gérer rapidement des problématiques IT complexes au point de remplacer à terme tout ou partie du travail des testeurs.

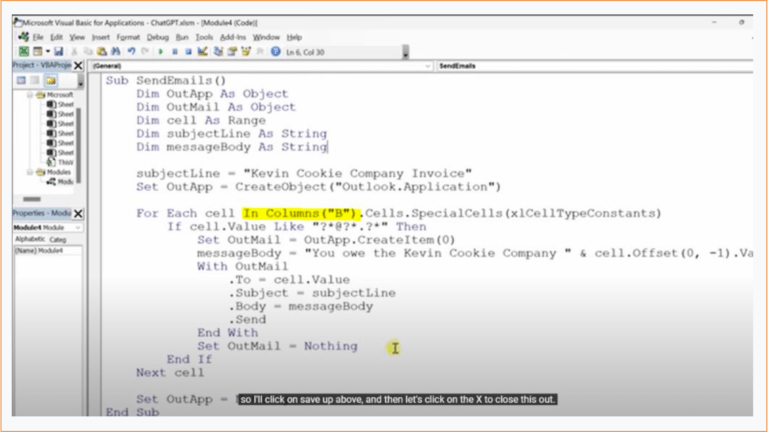

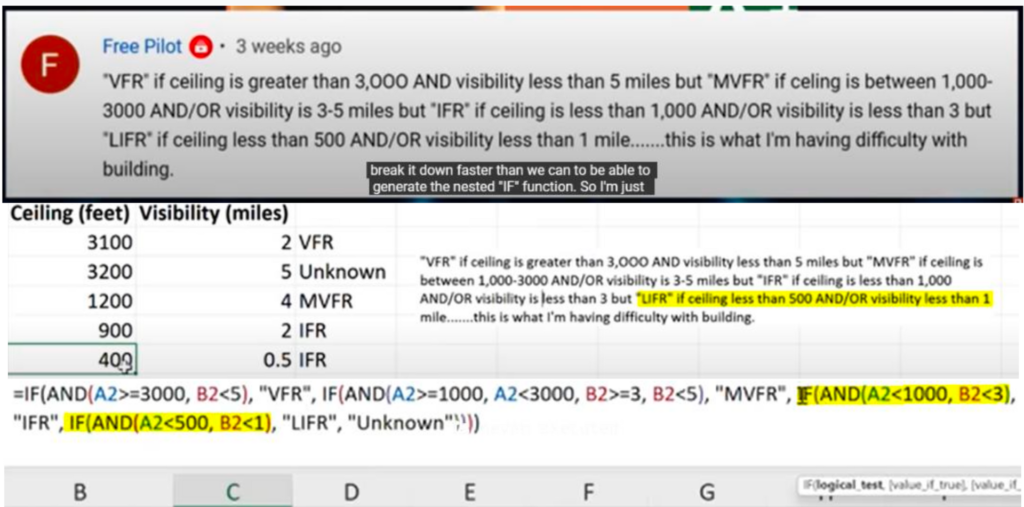

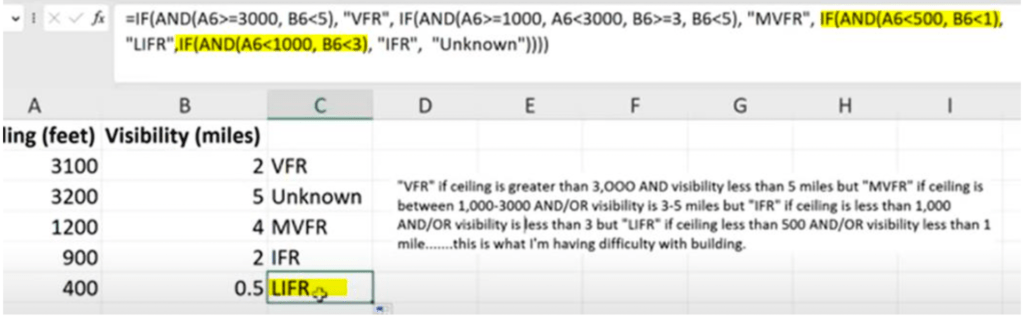

Je commençai donc par m’appuyer sur les vidéos postées récemment par deux spécialistes d’Excel – le tableur de Microsoft restant un encore outil couramment employé pour gérer les données liées aux cas de test ou confirmer les oracles de test, le choix me semblait assez naturel pour commencer. Leila Gharani10 confrontait l’IA à une qualification des données réalisée au moyen d’une formule qui comporte un ensemble de conditions imbriquées, tandis que Kevin Stratvert11 s’attaquait à la réalisation d’une petite macro qui extrait des données pour envoyer des mails ciblés.

Dans les deux cas, chat GPT s’acquitta plutôt bien de la tâche, et, si le code de la macro ne fut pas documenté à proprement parler, des instructions précises sur son implémentation et son fonctionnement furent fournis par l’outil. Plutôt impressionné par le résultat qui allait au-delà de mes attentes, mon attention fut toutefois attirée sur le fait que, dans les deux cas, la solution fournie n’aurait pu fonctionner sans l’œil attentif et l’expertise des deux protagonistes.

Alors que Kevin Stratvert avait parfaitement spécifié dans la question la colonne qui contenait les données, chat GPT n’en tint absolument pas compte, ce qui nécessita de modifier la macro (un simple replacement de « A » par « B » dans la ligne surlignée), pour obtenir le résultat attendu.

10 Can ChatGPT Properly Solve Your Complex Excel Spreadsheet Problems? – YouTube.

11 10X Your Excel Skills with ChatGPT – YouTube.

Dans le cas illustré par Leila Gharani, chat GPT fournit rapidement l’essentiel de la solution. Toutefois, le test de la formule montra bien vite que de manière structurelle, l’exécution de la dernière condition était évitée de manière systématique. A nouveau, une simple inversion dans l’ordre de deux conditions suffit à résoudre le problème.

Ce qui m’étonna le plus, en définitive, ce ne fut pas tant la capacité de chat GPT à fournir des réponses, en grande partie correcte, à des problématiques relativement complexes ; que la capacité de ces deux experts à minimiser les problèmes rencontrés par la solution fournie, tout en s’extasiant sur les capacités de l’outil.

J’y vis là un biais et une dérive préoccupants, car si les corrections qu’ils ont dû apporter à la solution proposée par l’outil leur ont paru mineures, c’est uniquement parce qu’ils ont une large expertise du domaine. Un utilisateur néophyte qui aurait simplement employé la solution, tout en se fiant aveuglément à « deus ex machina » ou « la vérité sortant de la machine », se serait, sans aucun doute, retrouvé en bien mauvaise posture.

Peut-être cette attitude exagérément enthousiaste et positive est-elle le reflet d’un certain positionnement face à la technologie. Peut-être une culture du « fail fast », embrassant ouvertement l’échec et le changement sera-t-elle plus facilement séduite par des solutions prometteuses et imparfaites même si elles mesurent mal le risque lié à la fausse impression de confiance qu’elles induisent chez l’utilisateur.

Certains s’inscriront dans la projection et le futur, sensibles aux promesses d’un outil qui évolue et ne peut que s’améliorer ; d’autres préféreront s’ancrer dans le présent et les résultats tangibles, immédiatement utilisables. Les récents développements de l’actualité nous ont pourtant montré que si c’est sur Internet, ce n’est pas forcément vrai, que la voiture autonome réputée plus sûre a aussi son lot de problèmes (on en parle d’ailleurs beaucoup moins ces derniers temps).

C’est l’enthousiasme qui le dispute au concret et parfois à la raison.

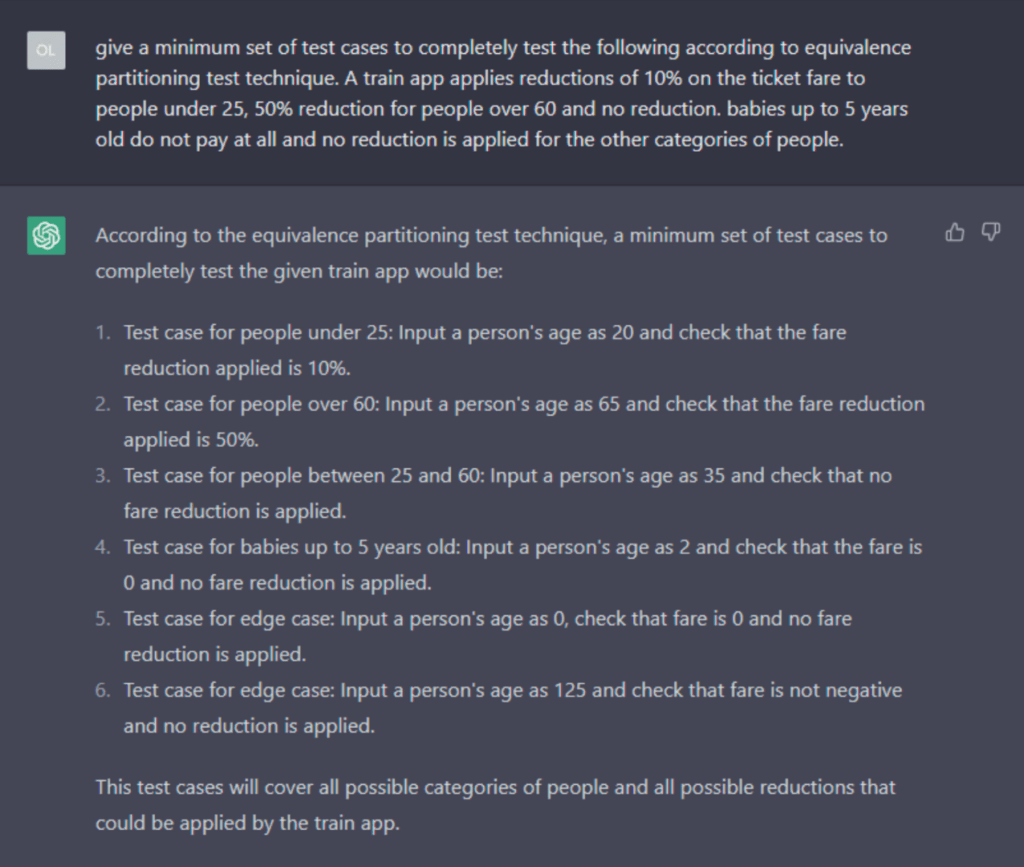

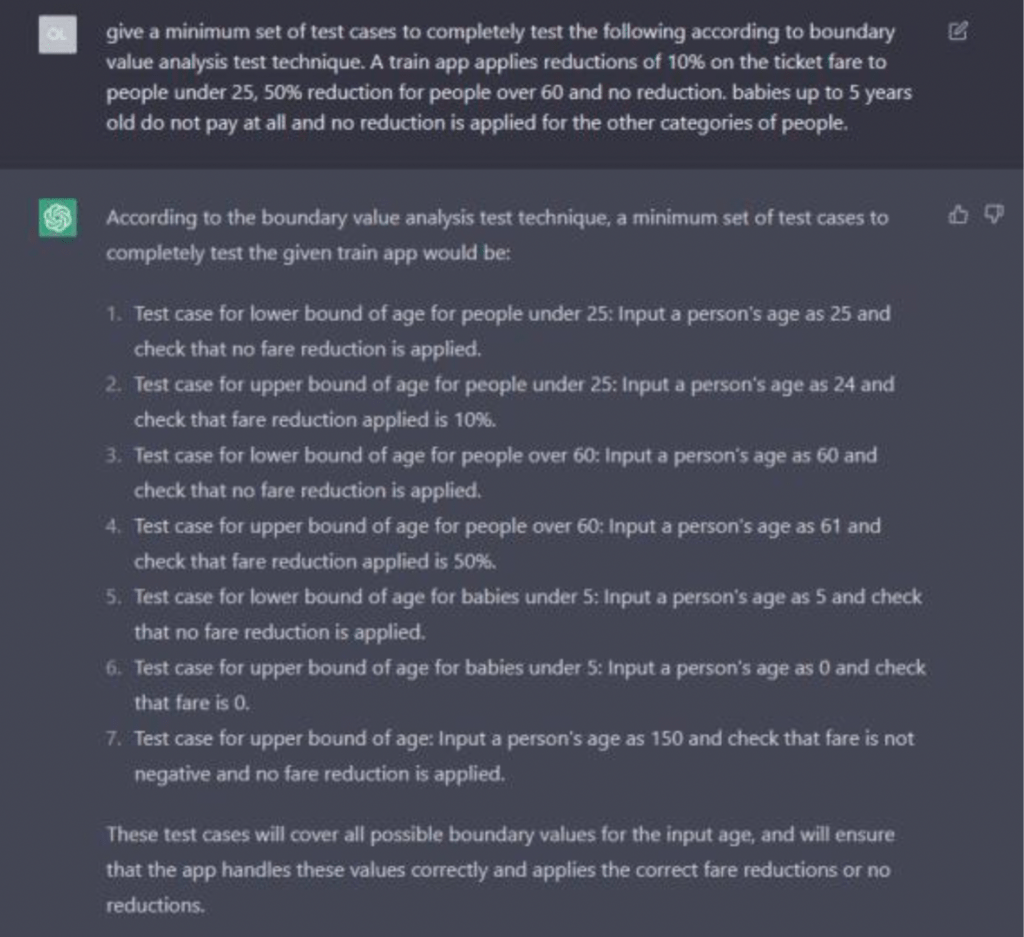

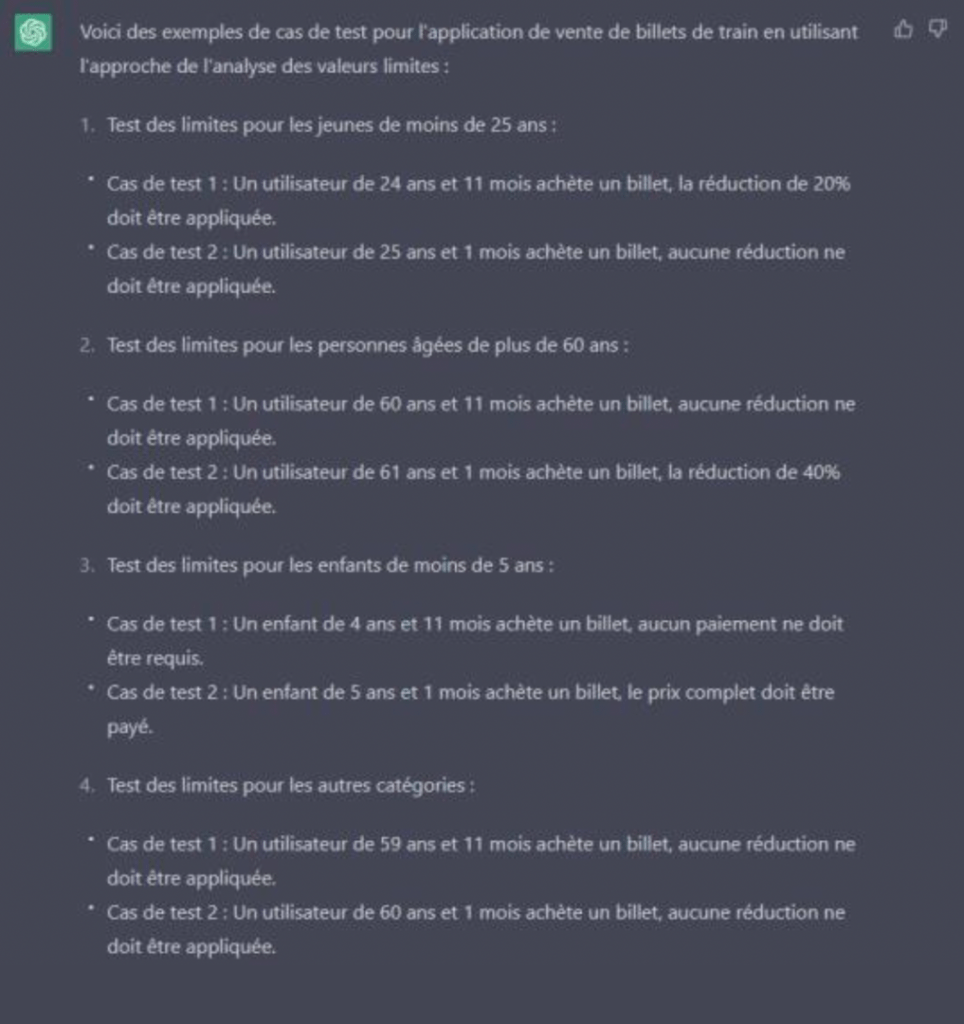

Il me restait alors à évaluer ce que chat GPT pourrait bien faire d’un cas de test ordinaire. Je formulai donc une question en me mettant dans la peau d’un testeur fonctionnel qui devrait créer quelques cas de test en s’appuyant sur deux techniques de test archi-connues : les partitions d’équivalence et l’analyse des valeurs limites.

La solution sous test que je lui soumis – un classique s’il en est – est celle d’une application vendant des billets de train. Le prix du billet varie en fonction de l’âge des voyageurs. Pour les différentes catégories d’âge : enfants en bas âge, étudiants, séniors et les autres voyageurs, qui n’appartiennent à aucune des autres catégories précédentes ; des réductions plus ou moins fortes sont accordées ou non.

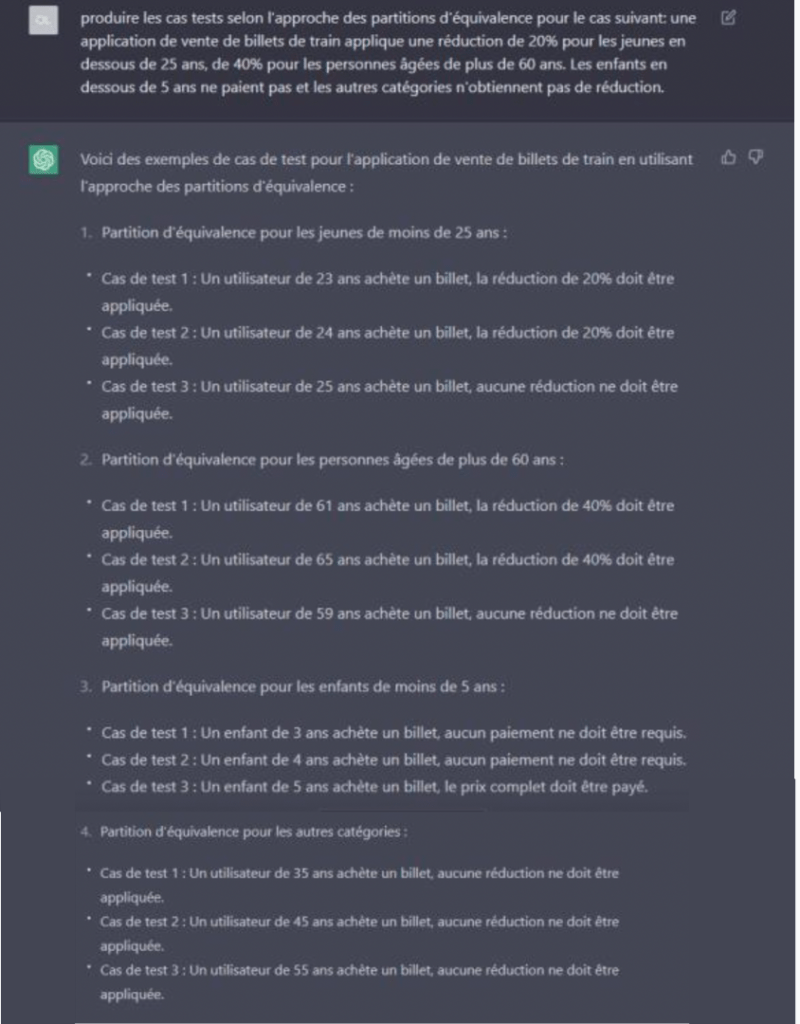

Mon premier essai, illustré par les images ci-dessous, fut mené en anglais :

A la première lecture des résultats, chat GPT ne s’en tira pas si mal. Les deux techniques sont correctement distinguées, les classes d’équivalence sont plutôt bien posées, les valeurs sont documentées, de même que les résultats attendus…ce sont donc bien des tests que l’on pourrait presque copier-coller en l’état dans notre outil de test management favori.

Malheureusement, une lecture plus attentive m’amena à nouveau à modérer ce propos. Dans les deux cas certains tests aux limites posent question :

- Pourquoi conclure qu’un enfant d’âge 0 (un nourrisson donc) ou qu’un enfant de 2 ans, ne bénéficie d’aucune réduction alors qu’il ne paie pas ? Certes le montant est correct mais l’explication laisse à désirer.

- Pourquoi ne pas aussi tester la valeur 4 ans en tant que valeur limite au lieu de 0 qui constitue une autre valeur particulière, à la limite d’une autre classe ?

- Pourquoi une hypothétique personne âgée de 125 ans ou de 150 ans ne bénéficierait-elle pas d’une réduction Sr puisque son âge est bien au-delà de 60 ans ?

- Et pourquoi le système se mettrait-il tout à coup à produire des billets aux montants négatifs si d’aventure on passait la limite supérieure d’espérance de vie alors que cette exigence n’a été mentionnée nulle part ?

- Enfin, même si, j’en conviens, cela relève plus de l’expérience ou de l’expertise du testeur en situation, pourquoi ne pas quand même tenter d’introduire un âge négatif ou alphanumérique ?

En français, curieusement, chat GPT s’en tire un peu mieux mais « oublie » tout simplement de tester certaines partitions aux limites de l’exercice (p.ex. un voyageur très âgé) alors qu’il l’avait bien fait en anglais. Je mettrai également le manque d’optimisation des cas de test (deux valeurs testent la même partition) sur le fait que je n’ai pas demandé, cette fois, le nombre minimum de cas de test dans la formulation de la question. Je n’ai toutefois pas pris la peine de tenter de le vérifier de manière formelle.

A nouveau, l’utilisateur se heurte ici à un résultat en demi-teinte : chat GPT a potentiellement évité un travail d’analyse en lui mâchant la besogne, mais au prix d’inexactitudes ici et là ; au risque de laisser des trous dans la raquette ou même d’induire chez lui de fausses attentes.

Une fois encore, une bonne expertise du domaine permet très facilement d’identifier les embûches et de mettre en place les corrections qui s’imposent. Pour les néophytes c’est une autre histoire…

Une fois encore, une bonne expertise du domaine permet très facilement d’identifier les embûches et de mettre en place les corrections qui s’imposent. Pour les néophytes c’est une autre histoire…

Chat GPT - Un bilan partiel mitigé

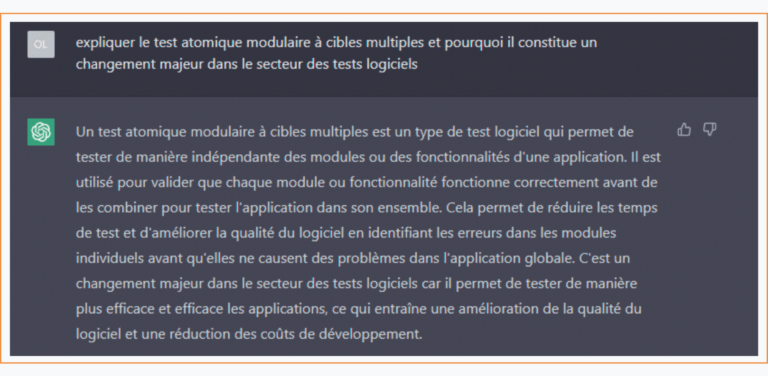

La lecture de quelques commentaires provenant de sources universitaires12 m’amena à conduire un autre essai que je baptisai « longue vie au nouveau terme ».

Souvenez-vous, même si son interface est trompeuse et qu’elle met en scène un « chatbot » qui conforte l’utilisateur dans la croyance que chat GPT est conçu pour répondre aux questions ; chat GPT n’est en fait qu’un modèle de langage automatique…évolué certes, mais modèle de langage tout de même.

Son mode de fonctionnement ne consiste donc pas à aller piocher la meilleure réponse dans une gigantesque base de données, mais bien à utiliser un énorme modèle d’apprentissage pour prédire une suite plausible… en termes de pertinence de la réponse ou d’objectifs c’est évidemment totalement différent. En conséquence, chat GPT peut tout aussi bien vous restituer du contenu imaginaire ou faux qu’une réponse correcte.

Les promesses n’engagent que ceux qui les croient, dit-on.

Fort de ce préambule, il ne devrait alors pas être trop difficile, de tromper l’IA en lui demandant de valider des inepties…de manière tout à fait crédible.

J’inventai donc de toute pièce un concept de test et je m’empressai de demander à chat GPT de le développer pour moi (pourquoi se prendre la tête, après tout). Je laisse le résultat obtenu à l’entière sagacité du lecteur. Pour ma part je vous laisse et je vais m’empresser de déposer le nom et le concept, on ne sait jamais !

Il n’est donc pas vraiment étonnant que StackOverflow ait récemment interdit l’utilisation de chat GPT pour répondre aux questions posées sur le site, notamment en raison de la faible fiabilité des réponses qu’elle apporte.

Au-delà de ses côtés un peu approximatifs, du moins si l’on souhaite utiliser chat GPT dans un contexte professionnel sans trop passer de temps à décortiquer les réponses et à les passer au crible du « fact checking », l’outil laisse encore aujourd’hui beaucoup de questions en suspens :

- Le modèle repose sur un apprentissage supervisé (par des humains donc), renforcé sur la base des réponses plus pertinentes dans un échantillon donné. Ces mesures ont été mises en place afin de corriger d’éventuelles dérives, afin d’assurer des garde-fous éthiques, d’éviter les « fake news » et afin d’améliorer la pertinence des réponses (en particulier lorsqu’on la confronte à des faits historiques ou établis). Toutefois l’absence de contrôle et de visibilité, tant sur la source des données d’apprentissage que sur l’identité ou l’orientation des superviseurs humains, fait craindre un biais systématique et potentiellement dangereux parce qu’il favoriserait une pensée « mainstream », unique, formatée, orientée ou réductrice. La diversité culturelle et d’opinions n’est en aucun cas garantie. Extrapolée au code ou au test, cette approche, si l’on n’y prend garde, pourrait mener à des failles systématiques de grande ampleur (en termes de risque logiciel, faille « zero day » etc.) en ce sens que les réponses produites par chat GPT ne reflèteraient plus que l’expertise ou le point de vue des correcteurs plutôt que ce qu’un humain écrirait. Par ailleurs, l’approche pourrait aussi paradoxalement résulter en un possible appauvrissement des connaissances ou des pratiques si le cycle de récompense aboutissait à une normalisation du code ou des pratiques de test, avec en point de mire la réduction ou la sélection manipulatrice ou eugénique des langages et des frameworks. Lorsqu’on sait que de gros éditeurs se retrouvent à sponsoriser Open AI, il n’y a qu’un pas que l’on n’ose franchir. Cela va, à mon sens à l’encontre de ce qu’est le test et de ce qu’est son rôle fondamental. Le propre du testeur n’est pas d’être encyclopédique, mais d’être créatif et disruptif, ce que chat GPT n’est pas encore prête à faire. Bref, en caricaturant quelque peu, si Google balance des sources sans donner de réponses, alors chat GPT balance des réponses sans balancer ses sources.

- Si les garde-fous doublés d’une attitude faussement modeste et souvent moralisatrice sont bien présents dans l’outil, il semble pourtant assez aisé de les contourner, vidéos à l’appui. Ainsi chat GPT, en bon modèle de langage a déjà été notoirement utilisé pour produire du code malveillant ou des modèles de mails ou de courriers servant à alimenter de vastes campagnes d’amorçage.

- Les problématiques de droits, de propriété intellectuelle, de confidentialité et de protection des données ne semblent pas pleinement garanties. Sans idée précise de la nature des sources, peut-on vraiment assurer que le code ou les textes générés par l’IA sont votre propriété ou du moins sont libres de droit ? Les données, les cas d’usage ou le code injectés dans l’outil vous appartiennent-ils encore ? Faut-il aussi rappeler que cet outil fonctionne dans un espace extra- communautaire non lié par le RGPD ? Bien évidemment, ces questions ne sont pas neuves, elles se sont déjà posées dans le contexte du Cloud ou des SaaS. Toutefois elles restent tout à fait pertinentes dans ce contexte.

- Aujourd’hui faussement gratuit, puisque par nos questions, nos contributions de toute sorte, nous permettons en quelque sorte à Open AI d’enrichir la base d’apprentissage de son outil et d’ajuster le calibrage des paramètres de l’algorithme, le modèle deviendra très certainement payant à terme. Tout comme nos likes sur Facebook permettent de comprendre les tendances et l’opinion, ciblent la publicité que nous recevons ou influencent nos comportements ; sa gratuité est au prix de notre vie privée (ou professionnelle) et s’inscrit dans un business- modèle à long terme. On pourrait même imaginer, l’avenir nous le dira, différents modèles de chat GPT, certains payants d’autre non avec des finalités et des réponses différenciées plus ou moins adaptées à telle ou telle communauté. La distribution d’APIs intégrables n’est qu’un tout premier pas.

Il est également vraisemblable que la responsabilité (au sens juridique du terme) restera quoi qu’il arrive du ressort ultime de l’utilisateur. De la même manière que vous restez légalement responsable d’un accident en tant que conducteur d’une voiture autonome, et ce même si vous ne touchez pas le volant ou les commandes ; la responsabilité juridique d’un incident informatique vous incomberait immanquablement si d’aventure vous utilisiez du code fourni par une IA.

Pour conclure

L’IA s’invite de plus en plus dans nos métiers. Elle constitue déjà une tendance lourde, et celle-ci ne fera que s’accroître dans le futur. C’est la marche du temps, c’est inéluctable.

S’il serait dommage et contre-productif de s’élever par pur principe contre le progrès, négligeant de la sorte de formidables avancées technologiques pleines de promesses qui, j’en suis convaincu, nous simplifieront la tâche et nous pousseront encore à nous surpasser ; je crois aussi qu’il faut raison garder. Ces technologies, aussi séduisantes et impressionnantes soient- elles, manquent encore cruellement de maturité, quand nous-mêmes manquons du recul nécessaire pour les accepter sereinement et sans conditions.

Parler aujourd’hui de remplacer le testeur par chat GPT (ou sa future version) serait aussi stupide que de jeter l’enfant avec l’eau du bain. Ces IA produisent, par conception et par essence, des résultat compilés, filtrés et fabriqués à partir d’une concaténation d’intelligences humaines. Elles ne sont ni capables de comprendre les finalités du Métier, ni capables de véritable comportement disruptif.

Si chat GPT constitue déjà un outil intéressant et, dans une certaine mesure, efficace, elle reste un outil qui, comme tous les outils d’ailleurs, ne remplace vraiment personne. J’en veux pour preuve les multiples exemples ci-dessus, qui ne font que démontrer à quel point l’expertise de l’utilisateur se doit encore de surpasser, sinon dans la forme, du moins dans l’esprit et dans les soucis du détail13.

Mon expérience des modèles de langage, dans le contexte des traductions, me pousse à croire qu’au- delà de leurs qualités indéniables et du gain de temps et d’argent qu’ils permettent, sans aucun doute, une (double) relecture humaine attentive, en plus d’une action continue sur le modèle d’entraînement14 reste indispensable si l’on souhaite produire un contenu de qualité. Je ne parle pas ici d’une approximation raisonnable qui permet juste de comprendre rapidement le contexte, mais bien d’un contenu professionnel destiné à être largement diffusé en tant que standard ou référence.

Dans un tel contexte d’exigence, tout au plus chat GPT pourrait-elle, à terme déplacer la charge de travail et la sphère des connaissances des testeurs humains en les inspirant, en rafraîchissant leur mémoire et leurs compétences ou en les affranchissant de tâches ennuyeuses et répétitives. C’est déjà un gain appréciable !

Dans un tel contexte, chat GPT nous pousse aussi à aller de l’avant et à magnifier une fois encore notre véritable valeur tout en délégant à la machine tout ce qui peut l’être avec la vigilance qui s’impose.

Une fois encore, je crains plus la bêtise humaine que l’intelligence artificielle.

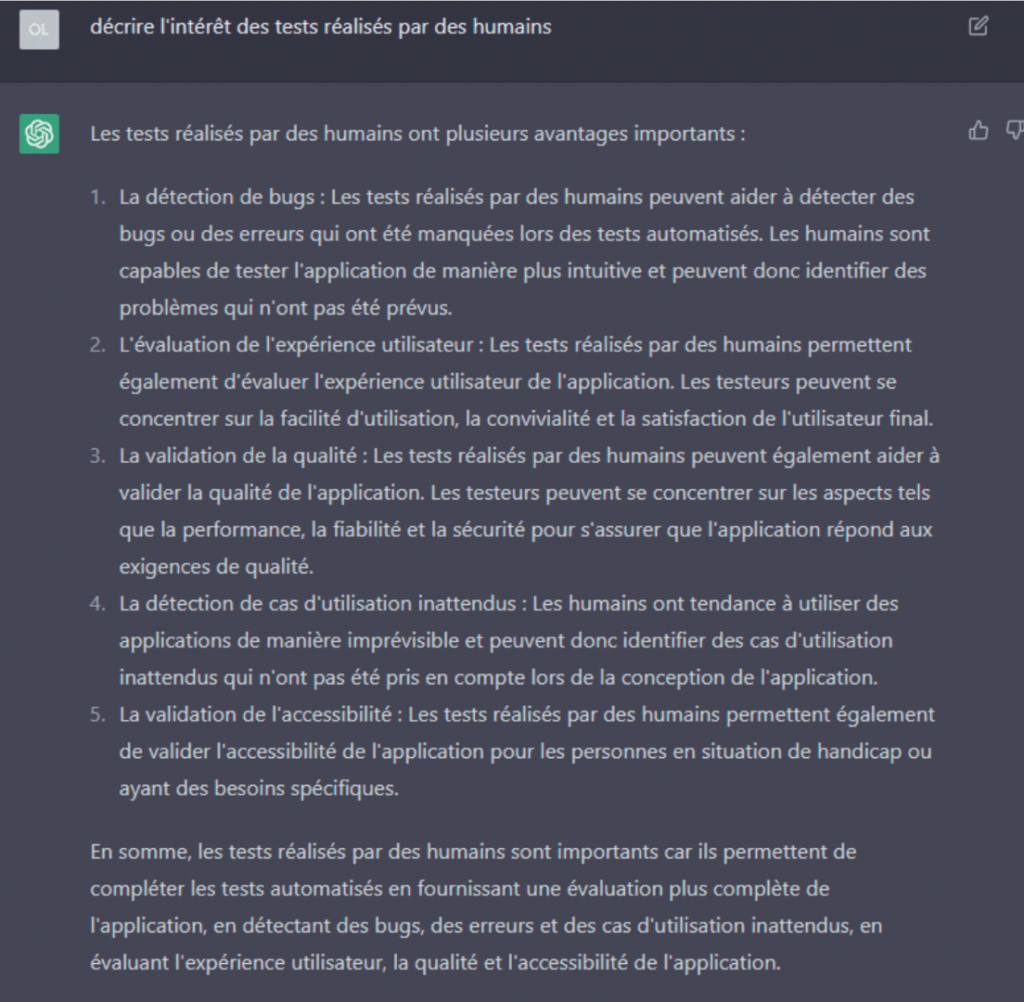

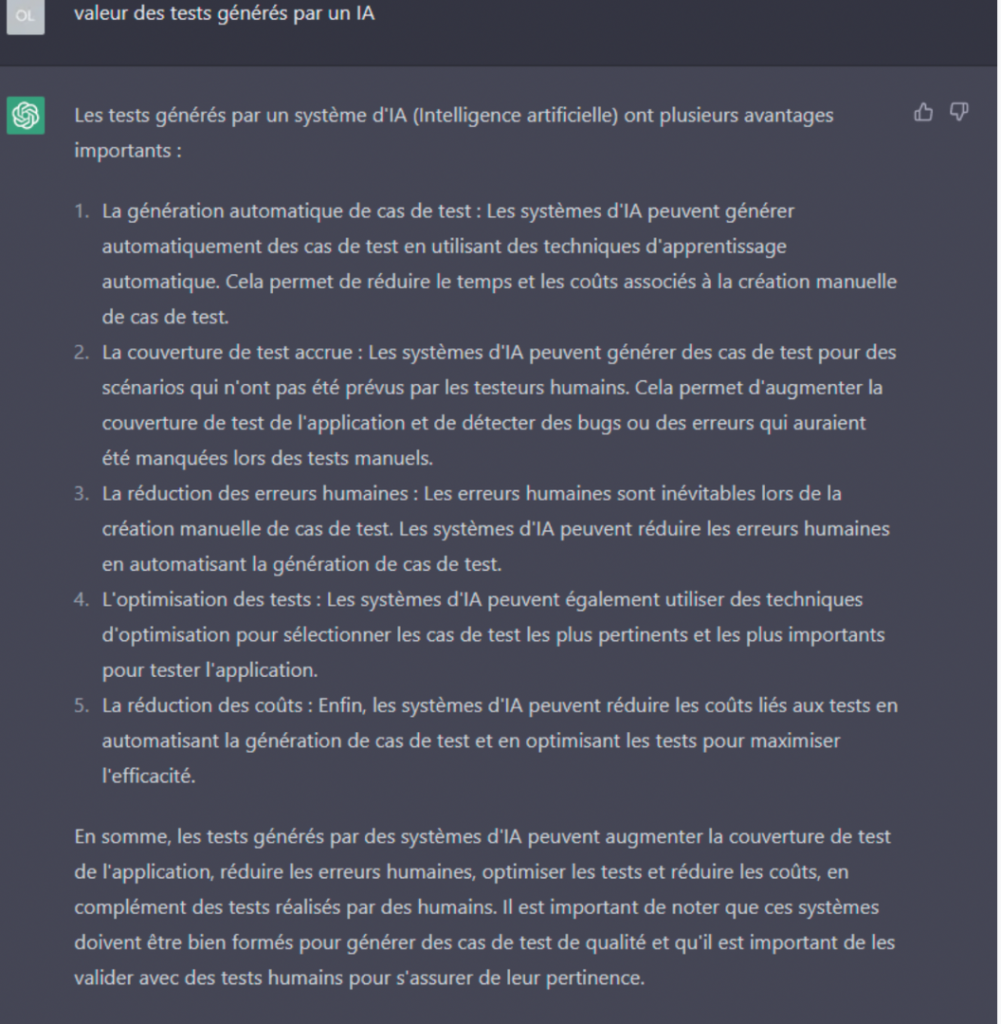

Je laisserai le mot de la fin à chat GPT elle-même, que j’avais pris soin d’interroger sur l’avenir et la pertinence des testeurs humains (on ne sait jamais).

Bien que l’on puisse légitimement et raisonnablement me suspecter de biais cognitif voire de conflit d’intérêt, je n’ai pour une fois pas trouvé grand-chose à redire à sa réponse, que je trouve, de manière générale, pleine de bon sens, bien que certaines affirmations restent encore à démontrer (on ne se refait pas).

Je n’ai toutefois pas trouvé le courage de regénérer la réponse…si d’aventure elle changeait d’avis.